近日,英博数科与中国人民大学、对外经济贸易大学研究团队联合开展的研究工作《Domain Specific Pruning of Large Mixture-of-Experts Models with Few-shot Demonstrations》正式被人工智能领域顶级会议 NeurIPS 2025 录用。

神经信息处理系统大会(Neural Information Processing Systems,简称NeurIPS)与国际机器学习大会(ICML)、国际学习表征会议(ICLR)并称“机器学习三大顶会”。据悉,第39届NeurIPS会议将于2025年12月2日至7日在美国圣地亚哥和墨西哥城两地同步举行。

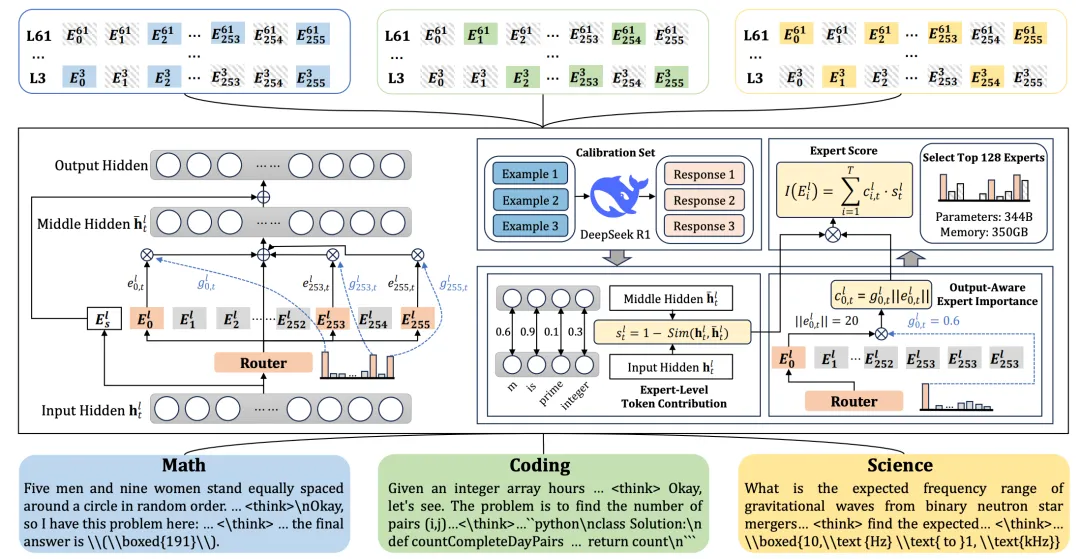

该研究聚焦于大规模混合专家模型(Mixture of Experts, MoE)的轻量化部署问题。混合专家模型通过只激活部分专家,在性能与推理效率之间实现了良好的平衡。然而,对于像DeepSeek-R1(671B)这样的超大规模 MoE 模型来说,在显存中加载所有专家,依然会产生巨大的资源开销,这也成为了模型部署时的主要瓶颈。

在本研究中,团队深入探究了大规模MoE 模型里的领域特化现象和专家冗余问题,首次系统揭示了少量示例专家定位(Few-Shot Expert Localization)现象:只要有少量的领域示例,模型就能稳定地激活一小部分稀疏的专家子集。在此基础上,团队提出了高效专家裁剪框架 EASY-EP,能够在保留一半专家的情况下维持完整模型的性能,并实现最高2.99倍推理吞吐提升。

与此前arXiv 公布的版本相比,本次中稿研究进一步补充和验证了新的发现:对于原本需要路由至已剪枝专家的Token,若不再进行路由,能够在进一步降低计算量的同时基本保持模型性能。这一发现为EASY-EP方法的落地应用提供了新的价值。

本研究由英博数科和中国人民大学、对外经济贸易大学联合提出创新方法思路,英博数科为实验验证提供了全程算力支持。

此次研究展示了在大规模MoE 模型中,结合现象发现与高效剪枝策略所带来的新机遇。未来,团队将进一步探索面向企业级场景的模型裁剪与推理加速方案,推动大模型技术的高效落地。

【论文信息】

论文题目:

Domain Specific Pruning of Large Mixture-of-Experts Models with Few-shot Demonstrations

论文链接:

https://arxiv.org/abs/2504.06792

开源链接:

https://github.com/RUCAIBox/EASYEP

英博数科GPU算力金秋感恩福利!

- 4090低至0.88元/卡时

- A800低至4.92元/卡时

- H800低至10.76元/卡时

活动于2025年9月30日截止。